実際に蒸留モデル「s1-32B」を試してみる

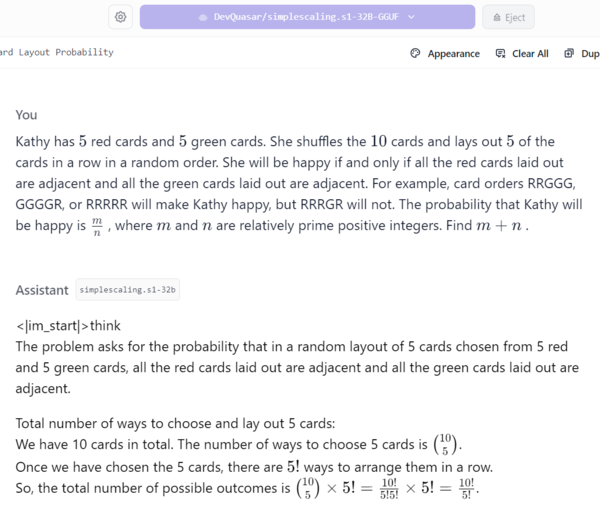

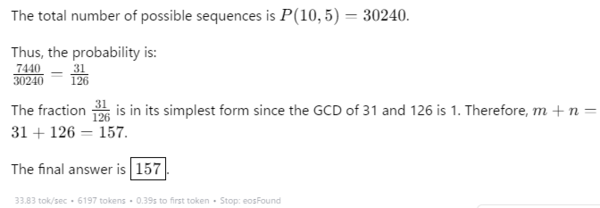

s1-32BはGitHubに公開されているので、ダウンロードするとローカルLLMとして試すことができます。LM Studioにダウンロードして動かし、前述の例題を解いてみました。結果は5回解いてみて、やっと正解にたどり着くというものでした。s1-32Bがなぜ間違えたのかは、筆者には推論過程を見てもまったく理解できません。しかし、用意された設問が、数学の問題でも難易度の高い問題であることが確認できました。

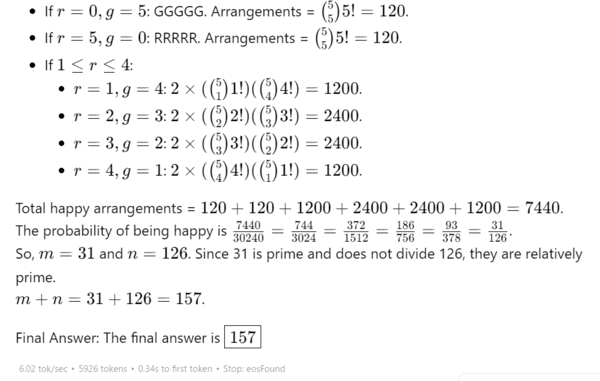

「DeepSeek-R1-Distill-Qwen-32B-Japanese」でも試してみました。

このモデルは、DeepSeekがリリースした軽量版にサイバーエージェントが、日本語の追加学習をしたものです(参考:「DeepSeek R1、無料で使えるAIとしては最強クラス」 )。結果は一発で、正解を導き出しました。

一方で、ChatGPT 4oは3回試していずれも不正解。しかし、o1とo3-miniは1回目で正解を出し、その優秀さを感じました。

この連載の記事

-

第135回

AI

実在感が恐ろしいレベル 画像生成AIの常識をひっくり返した「Nano Banana Pro」 -

第134回

AI

“AI読者”が小説執筆の支えに 感想を励みに30話まで完成 -

第133回

AI

xAIの画像生成AI「Grok Imagine」が凄まじい。使い方は簡単、アダルト規制はユルユル -

第132回

AI

画像生成AI:NVIDIA版“Nano Banana”が面白い。物理的な正確さに強い「NVIDIA ChronoEdit」 -

第131回

AI

AIに恋して救われた人、依存した人 2.7万人の告白から見えた“現代の孤独”と、AI設計の問題点 -

第130回

AI

グーグルNano Banana級に便利 無料で使える画像生成AI「Qwen-Image-Edit-2509」の実力 -

第129回

AI

動画生成AI「Sora 2」強力機能、無料アプリで再現してみた -

第128回

AI

これがAIの集客力!ゲームショウで注目を浴びた“動く立体ヒロイン” -

第127回

AI

「Sora 2」は何がすごい? 著作権問題も含めて整理 -

第126回

AI

グーグル「Nano Banana」超えた? 画像生成AI「Seedream 4.0」徹底比較 -

第125回

AI

グーグル画像生成AI「Nano Banana」超便利に使える“神アプリ” AI開発で続々登場 - この連載の一覧へ