約6ドルの学習費用で「o1-preview」レベルを実現

蒸留法を使ったLLMの追加学習に非常に効果があることを証明する研究も登場しました。2月6日に、スタンフォード大学とワシントン大学のAI研究者が発表したのは、蒸留手法を使うことで、非常に安価で高性能なLLMを開発できるという研究です。「s1-32B」というモデルとして公開されています。

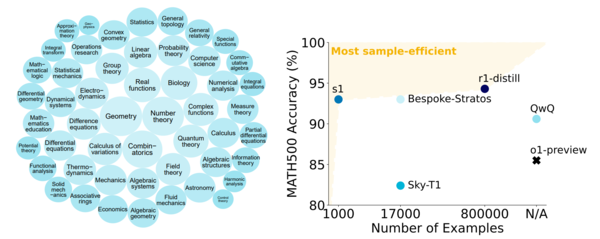

この研究では、事前トレーニングとして、学習しやすいように入念に設計された難易度、多様性、品質の3つを基準にした1000の質問と回答のペアを準備します。その回答を作成するために、グーグルのLLM「Gemini2.0」のAPIを利用して推論させ、それらをデータセット「s1K」としてまとめます。この優れたLLMの推論過程も学習用データセットに含める点が、蒸留による学習手法の肝です。質問に用意された分野は、「線形代数」「幾何学」「確率論」「生物学」「量子力学」など、多岐にわたる科目・トピックが用意されています。

s1kで扱われている質問のジャンル(左)、いくつの設問を学習に使い「競技数学500問」の正答率のLLM別の比較(右)。DeepSeek R1蒸留タイプ(r1-distill)は80万問を用意しているのに対し、s1-32B(s1)は1000問しか用意していないにも関わらず、正答率はほとんど変わらない(「s1: Simple test-time scaling」より )

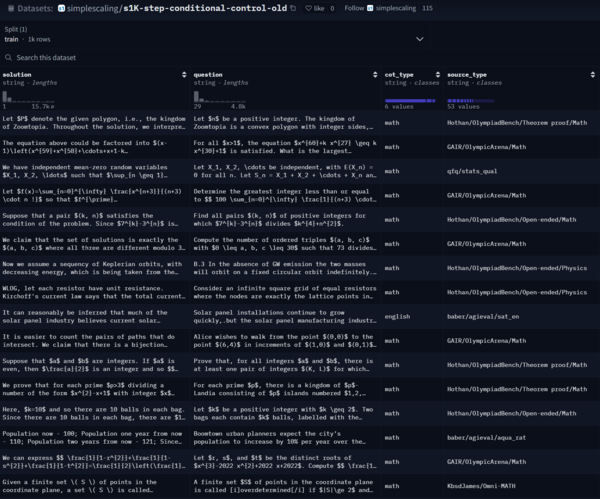

公開されているデータセットs1k。回答(Solution)と質問(Question)、思考過程からなる。各設問はそれぞれ専門知識を問うもので難易度が高く、いくつか読んでみたが、質問自体が何を問われているのかわからない難しさ

例えば、質問と回答の一例としては下記のようなものでした。筆者にはこの問題の難易度が判断できないので、o1に聞いたところ、アメリカの高校生向け数学コンテスト(AIME)で使われる水準の問題とのことでした。

このデータセットを使い、アリババのLLM「Qwen2.5-32B-Instruct」をベースに追加学習して、s1-32Bを開発しました。学習には、NVIDIA H100 GPUを16基使用し、約26分間で完了したとしています。その際の計算コストは約6ドル(約910円)と報告されています。

その結果、2024年9月にリリースされたOpenA1 o1-previewと比較した場合、「MATH(競技数学500問のベンチマーク)」で、o1-previewが85.5%の正答率に対して、s1-32Bは93%と7.5%の向上、「AIME24(アメリカ招待数学試験2024年版)」でOpenAI o1-preview: 44.6%の正答率に対して、s1-32B: 56.7%と27%の向上と、学習させた数学等の分野について大幅な性能向上を実現できたとしています。

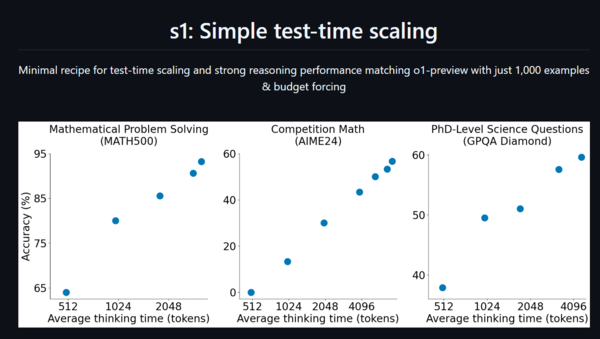

興味深いのが、当初は5万9000問の設問と回答と推論とを用意していたようですが、それより1000問に絞り込んだほうが結果はよかったということです。厳選された設問と思考過程の方が、AIの追加学習に対して、より優れた結果を生み出すようです。また、推論する時間を長く取れば取るほど、正答率も上がっていくとしています。

DeepSeekは厳密には同じではないようですが、o1にAPIを通じて大量の質問を投げ、その回答と推論過程を学習データとして使うことで高性能なLLMを比較的安価に生み出すことができたようです。

トークン数が増えていくに従って、正答率が上がっている。左から「数学問題」、「競技数学」、「博士課程レベルの質問」。100トークンは英文約300字、日本語で約120字(「s1: Simple test-time scaling」より )

この連載の記事

-

第135回

AI

実在感が恐ろしいレベル 画像生成AIの常識をひっくり返した「Nano Banana Pro」 -

第134回

AI

“AI読者”が小説執筆の支えに 感想を励みに30話まで完成 -

第133回

AI

xAIの画像生成AI「Grok Imagine」が凄まじい。使い方は簡単、アダルト規制はユルユル -

第132回

AI

画像生成AI:NVIDIA版“Nano Banana”が面白い。物理的な正確さに強い「NVIDIA ChronoEdit」 -

第131回

AI

AIに恋して救われた人、依存した人 2.7万人の告白から見えた“現代の孤独”と、AI設計の問題点 -

第130回

AI

グーグルNano Banana級に便利 無料で使える画像生成AI「Qwen-Image-Edit-2509」の実力 -

第129回

AI

動画生成AI「Sora 2」強力機能、無料アプリで再現してみた -

第128回

AI

これがAIの集客力!ゲームショウで注目を浴びた“動く立体ヒロイン” -

第127回

AI

「Sora 2」は何がすごい? 著作権問題も含めて整理 -

第126回

AI

グーグル「Nano Banana」超えた? 画像生成AI「Seedream 4.0」徹底比較 -

第125回

AI

グーグル画像生成AI「Nano Banana」超便利に使える“神アプリ” AI開発で続々登場 - この連載の一覧へ