サポートされる命令は極小

プログラムも独自仕様

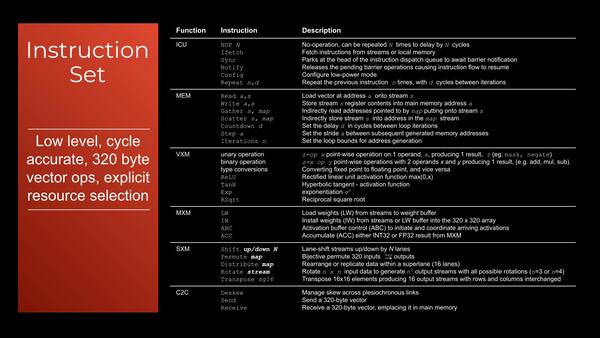

下の画像がTSPでサポートされる命令のすべてである。サポートされる命令はご覧の通り非常に少ない。だからこそ個々のTileを小さくまとめられるという話でもあると思うが。

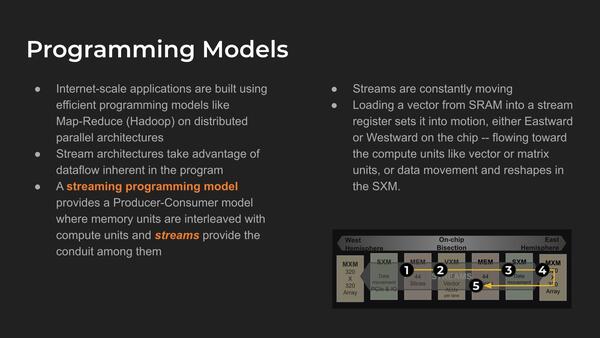

こういう特異な構成なので、プログラムも当然独自のものが必要となる。そもそもStreamを前提としているあたりで、通常のプログラミングモデルがまったく利用できないのは当たり前ではある。

独自仕様のプログラム。Map-Reduceはクラウドなどのスケールアウト環境で、多数のマシンで分散処理して、最終的にその結果を集約するプログラムであるが、それに似ているというのもわかるようなわからないような感じだ

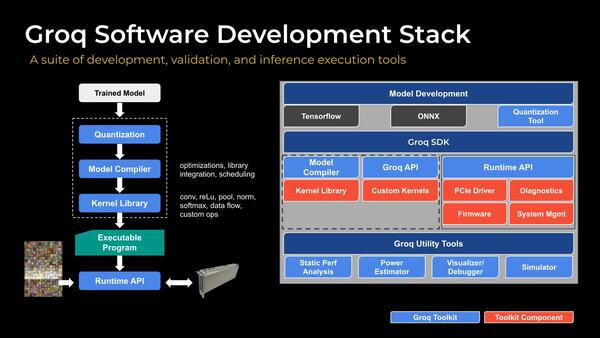

もちろんGroqからはソフトウェアフレームワークというか、ソフトウェアスタックが提供されるとしているが、現状まだ十分にそろってるとは言い難いように思える。このあたりは今後の課題だろう。

フレームワークとしてTensorflowと、ランタイムとしてONNXをサポートするとしているが、まだKernel LibraryやPCIe Driverなどは用意が間に合ってない模様。このあたりは徐々に提供予定なのだろう

インテルのHabana GOYAやNVIDIAのV100を

はるかに上回る圧倒的性能

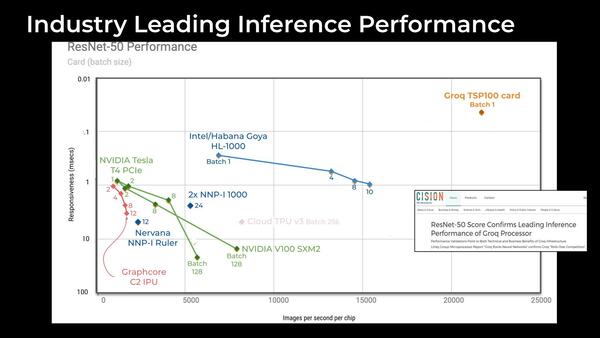

このGroqのTSPが、以前から話題になっていたのはその性能の高さである。下の画像は、縦軸が応答時間(Latency)、横軸が毎秒の画像処理枚数である。テストそのものはResNet-50での結果であるが、圧倒的に高い数字を叩き出しているのがわかる。

連載575回で、インテルが買収したNervana Systemsのリソースを全部捨てて、代わりにHabana Labsを買収しなおしてこちらを中核に据えたという話をしたが、そのHabana LabsのGOYAと比較しても性能は圧倒的である。

今年1月にMicroProcessor ReportがGroqのTSPを報じた際の数字で言えば、NVIDIAのV100が1.5GHz駆動で250TOPSとされるのに対し、TSPは1GHz駆動で820TOPSの性能になるとされていた。

実際上の画像でもわかるが、V100ではResNet-50での処理性能は最大でも7907枚/秒、GOYAでも1万5453枚/秒なのに対し、TSPは2万400枚/秒に達するとしている。

ちなみにここまでのスライドは、今年4月に開催されたLinley Processor Conferenceで発表されたもので、まだA0シリコンということもあって動作周波数は控えめ(前述のダイ写真では900MHzで750TOPSとされる)だったが、その後改良を重ねたようで、現在は公式に1.25GHzで1PetaOPS/秒、FP16で250TFLOPSという処理性能に引き上げられている。

Groqのメリットは、外部にメモリーを置かないで内蔵SRAMだけでカバーすることで、220MBという相対的に大容量のメモリー容量と、80TB/秒という強烈なメモリー帯域を両立できたことである。もっともその代償が268億個のトランジスタと725mm2という巨大なダイサイズになる。

ただ、それこそHabanaのGAUDIなどと異なり外部にHBM2を搭載したりしないし、14nmを使って725mm2なので、同じ性能で良ければ7nmに移行すればダイサイズは半分近くに抑えられるだろう。

もっとも、AI業界はだいたいダイサイズを縮めずに、その分演算ユニットとメモリー容量を増やす方向に走りがちである。したがって、仮に7nmに移行すると500MB弱のオンチップSRAMと、40本のSuperLaneを持ち、2Peta OPS/秒の性能を持つ製品が登場しそうではある。

4月以降のGroqは、6月に開催されたISCA(International Symposium on Computer Architecture)でTSPの内部構造に関して論文を発表したくらいであまり動きがない。

ただ今年9月末~10月にかけて開催される2020年のAI Hardware Summitに、再びゴールドスポンサーとして参加しており、なにかしらの話がここで出てくるものと期待されている。

また今年10月末に開催されるLinley Fall Processor Conference 2020でも、“Delivering Machine Learning at Scale”というタイトルの講演が用意されており、ここでもう少し細かい話が出てくるかもしれない。

AI向けチップというのは、たとえInference(推論)向けであっても、やっぱりお化けのようなチップになるという一つの例であろう。

この連載の記事

-

第852回

PC

Google最新TPU「Ironwood」は前世代比4.7倍の性能向上かつ160Wの低消費電力で圧倒的省エネを実現 -

第851回

PC

Instinct MI400/MI500登場でAI/HPC向けGPUはどう変わる? CoWoS-L採用の詳細も判明 AMD GPUロードマップ -

第850回

デジタル

Zen 6+Zen 6c、そしてZen 7へ! EPYCは256コアへ向かう AMD CPUロードマップ -

第849回

PC

d-MatrixのAIプロセッサーCorsairはNVIDIA GB200に匹敵する性能を600Wの消費電力で実現 -

第848回

PC

消えたTofinoの残響 Intel IPU E2200がつなぐイーサネットの未来 -

第847回

PC

国産プロセッサーのPEZY-SC4sが消費電力わずか212Wで高効率99.2%を記録! 次世代省電力チップの決定版に王手 -

第846回

PC

Eコア288基の次世代Xeon「Clearwater Forest」に見る効率設計の極意 インテル CPUロードマップ -

第845回

PC

最大256MB共有キャッシュ対応で大規模処理も快適! Cuzcoが実現する高性能・拡張自在なRISC-Vプロセッサーの秘密 -

第844回

PC

耐量子暗号対応でセキュリティ強化! IBMのPower11が叶えた高信頼性と高速AI推論 -

第843回

PC

NVIDIAとインテルの協業発表によりGB10のCPUをx86に置き換えた新世代AIチップが登場する? -

第842回

PC

双方向8Tbps伝送の次世代光インターコネクト! AyarLabsのTeraPHYがもたらす革新的光通信の詳細 - この連載の一覧へ